Uma equipe de engenheiros da Universidade da Califórnia, San Diego (UCSD), alcançou recentemente um avanço significativo, desenvolvendo um novo método que permite que grandes modelos de linguagem (LLMs) aprendam novas tarefas com menos dados e recursos computacionais. Os modelos LLM normalmente consistem em bilhões de parâmetros que determinam como eles processam informações. Os métodos tradicionais de ajuste fino exigem o ajuste de todos os parâmetros, o que é custoso e propenso a sobreajuste, afetando o desempenho do modelo em novos dados.

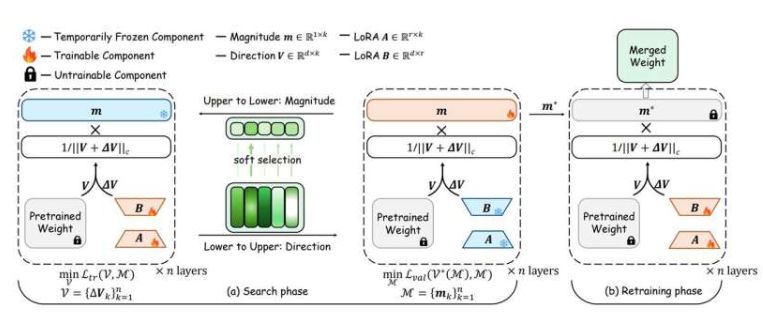

Para solucionar esse problema, os engenheiros da UCSD propuseram uma nova estratégia inteligente. Esse método não reconfigura todo o modelo, mas sim atualiza com precisão as partes mais críticas. Comparado aos métodos de ajuste fino existentes, esse método é menos custoso, mais flexível e melhor em generalizar o conhecimento aprendido para novos contextos.

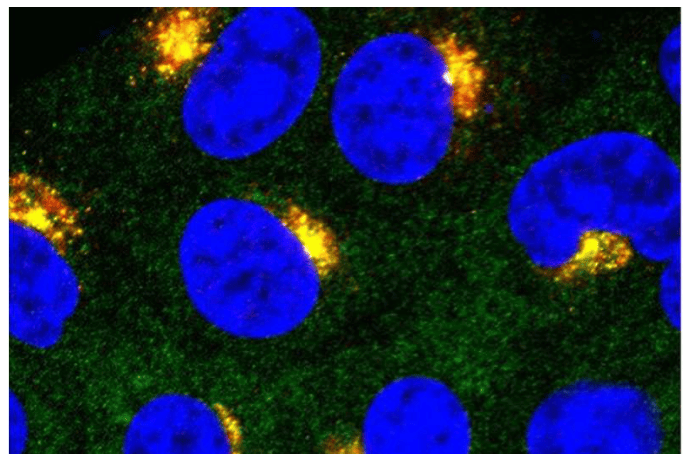

A equipe de pesquisa demonstrou que, mesmo com dados de treinamento extremamente limitados, esse método pode ajustar com eficácia um modelo de linguagem de proteínas usado para prever propriedades de proteínas. Por exemplo, na previsão da capacidade de um peptídeo atravessar a barreira hematoencefálica, o novo método supera os métodos tradicionais em precisão, apesar de uma redução significativa no número de parâmetros (326 vezes). Na previsão da estabilidade térmica de proteínas, com uma redução de 408 vezes no número de parâmetros, seu desempenho é comparável ao de um método totalmente ajustado. Pengtao Xie, professor de Engenharia Elétrica e de Computação na Escola de Engenharia Jacobs da UC San Diego, afirmou: "Com nosso método, pequenos laboratórios e startups podem adaptar grandes modelos de IA às suas necessidades sem a necessidade de supercomputadores ou grandes conjuntos de dados."