Pesquisadores de segurança desenvolveram com sucesso o primeiro mecanismo de defesa funcional para resistir eficazmente a ataques de criptoanálise direcionados aos parâmetros de modelos de sistemas de inteligência artificial (IA). Como propriedade intelectual de alto valor, o roubo de parâmetros de modelos de sistemas de IA sempre representou uma grande ameaça para o setor. Ashley Kurian, doutoranda da Universidade Estadual da Carolina do Norte e primeira autora do artigo, afirmou: "Nossa tecnologia defende eficazmente contra esses ataques".

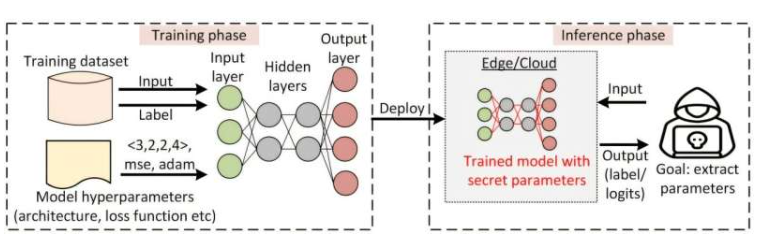

Ataques de extração de parâmetros por criptoanálise, que utilizam métodos matemáticos para determinar os parâmetros de modelos de IA, permitem que terceiros recriem o sistema, representando uma séria ameaça para sistemas comerciais de IA, especialmente modelos de redes neurais. O autor correspondente do artigo, Aidin Isu, destacou: "Ataques de criptoanálise têm se tornado cada vez mais frequentes e eficazes, e precisamos urgentemente de mecanismos de defesa para impedir o roubo de parâmetros de modelos".

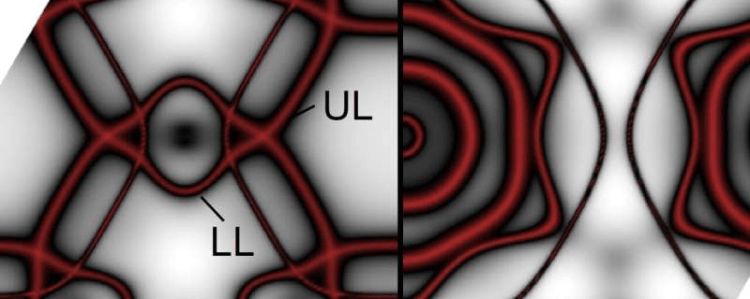

O novo mecanismo de defesa baseia-se na compreensão dos pesquisadores sobre o princípio fundamental do ataque: ele visa principalmente as diferenças entre os neurônios. Kurian explicou: "Treinamos o modelo de rede neural para tornar os neurônios na mesma camada semelhantes entre si, estabelecendo uma 'barreira de similaridade' para aumentar a dificuldade do ataque". Em testes de prova de conceito, o modelo de IA que incorpora o mecanismo de defesa apresentou uma variação de precisão inferior a 1% e resistiu eficazmente a ataques de criptoanálise de longa duração.

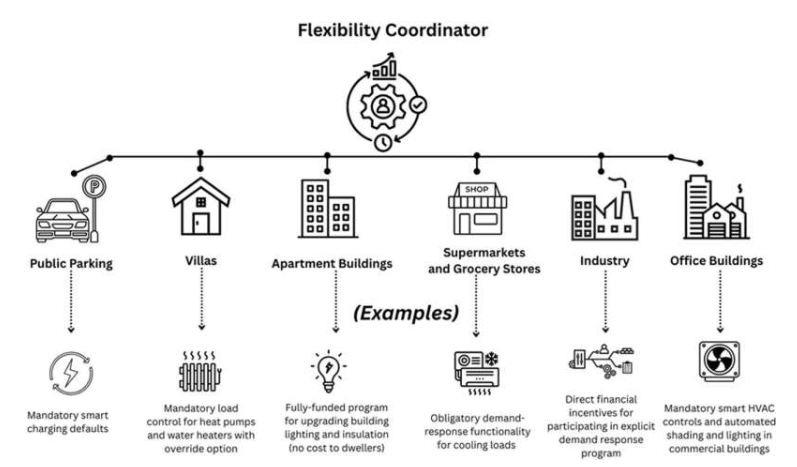

Além disso, a equipe de pesquisa desenvolveu uma estrutura teórica para quantificar a probabilidade de sucesso de ataques de criptoanálise, permitindo a avaliação da resiliência do modelo sem a necessidade de testes de ataque prolongados. Kurian afirmou: "Estamos otimistas de que esse mecanismo será usado para proteger sistemas de inteligência artificial e estamos dispostos a colaborar com parceiros da indústria para implementá-lo". Aisu também enfatizou que existe uma constante disputa entre a proteção da segurança e os ataques de hackers, e espera que mais recursos sejam destinados ao desenvolvimento de novas medidas de segurança no futuro.

O artigo de pesquisa, "Training Defense: The First Line of Defense Against Cryptanalysis Neural Network Parameter Extraction Attacks" (Defesa de Treinamento: A Primeira Linha de Defesa Contra Ataques de Extração de Parâmetros de Redes Neurais por Criptoanálise), será apresentado na 39ª Reunião Anual de Sistemas de Processamento de Informação Neural, em San Diego, Califórnia, de 2 a 7 de dezembro.